Deepfake掀起的新科技犯罪風暴 專家教你4招肉眼破解技巧

記者/馬麗昕

2022年3月烏俄戰爭白熱化期間,一支「澤倫斯基要求烏克蘭軍人投降」的深偽影片,引起全球關注。而在此之前,台灣也發生網紅販賣以Deepfake製作的名人色情影片,引發社會譁然,也讓台灣社會開始重視Deepfake帶來的資安風暴。

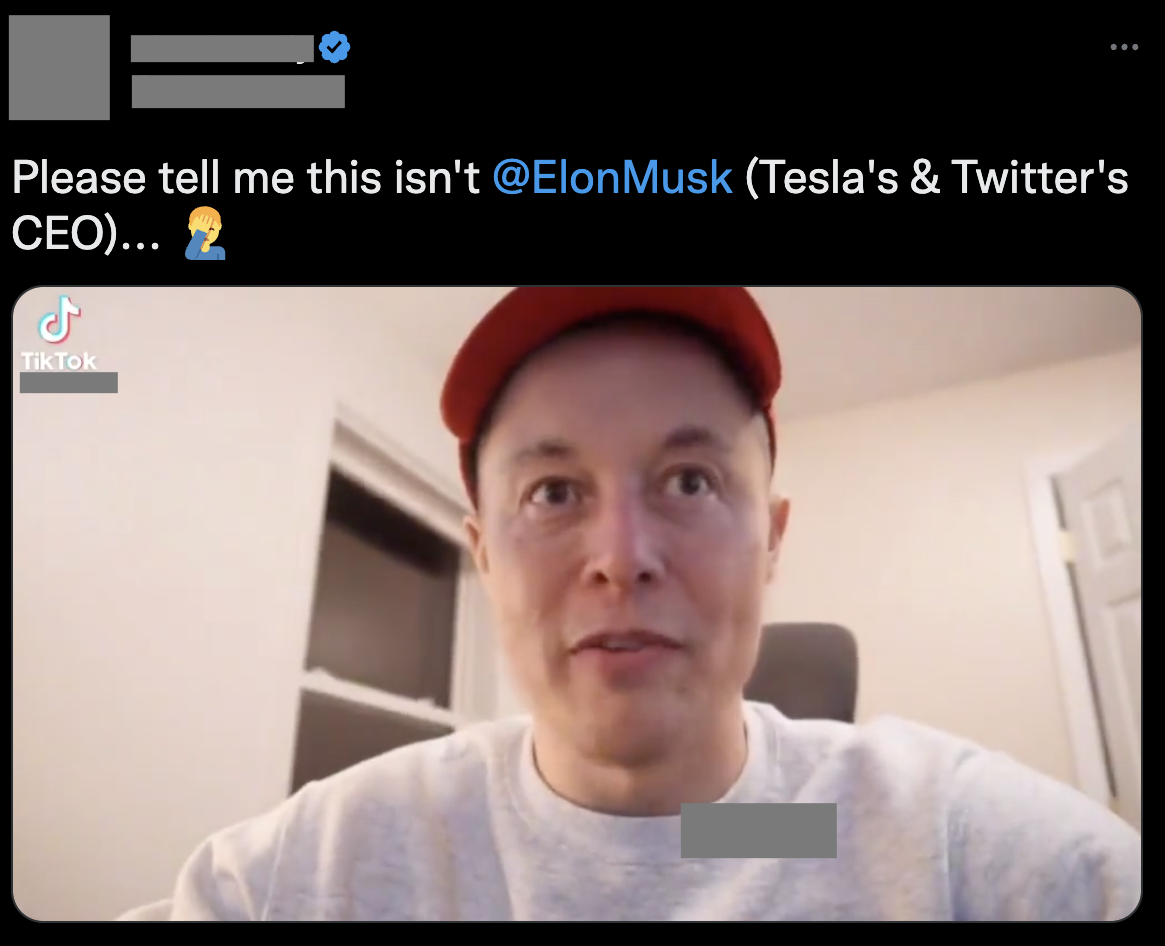

查核中心近期破解一支冒充成特斯拉總裁馬斯克(Elon Musk)的深偽影片。影片中的「馬斯克」神情恍惚,他自稱嗑藥,又說「感覺超嗨,準備設計30輛嶄新的太空車去火星」。

圖卡版(可左右滑動喔)

勁爆的言論、模糊的影像品質,讓人難以辨認真假,更有網友說「請告訴我這不是特斯拉與推特的總裁馬斯克」。記者實際追影片來源,影片其實是一個名為「The AI guy」的Tik Tok用戶,用深偽技術所創立的假「馬斯克」影片。

這位創作者自述,他是利用「馬斯克」與其他人互動的公開片段,以AI面部與聲音的過濾器所創作出來。

圖1:推特上流傳馬斯克的深偽影片/擷取自推特

愈來愈多的案例顯示,從色情復仇到政治假訊息、詐騙等領域,都是Deepfake技術觸及之地,且其愈來愈進步的技術,也讓民眾難以辨認真假,若在戰爭、選舉時間發布Deepfake假訊息混淆認知,更將帶來難以忽視的資訊危機。

本篇採訪成功大學統計系教授許志仲、中研院資訊創新研究所助理研究員陳駿丞,提供4招辨認深偽影片的技巧;專家也提醒,民眾須認識深偽技術,保持警覺意識,才是打假的第一步。

名人公開影像多 成為訓練深偽好素材

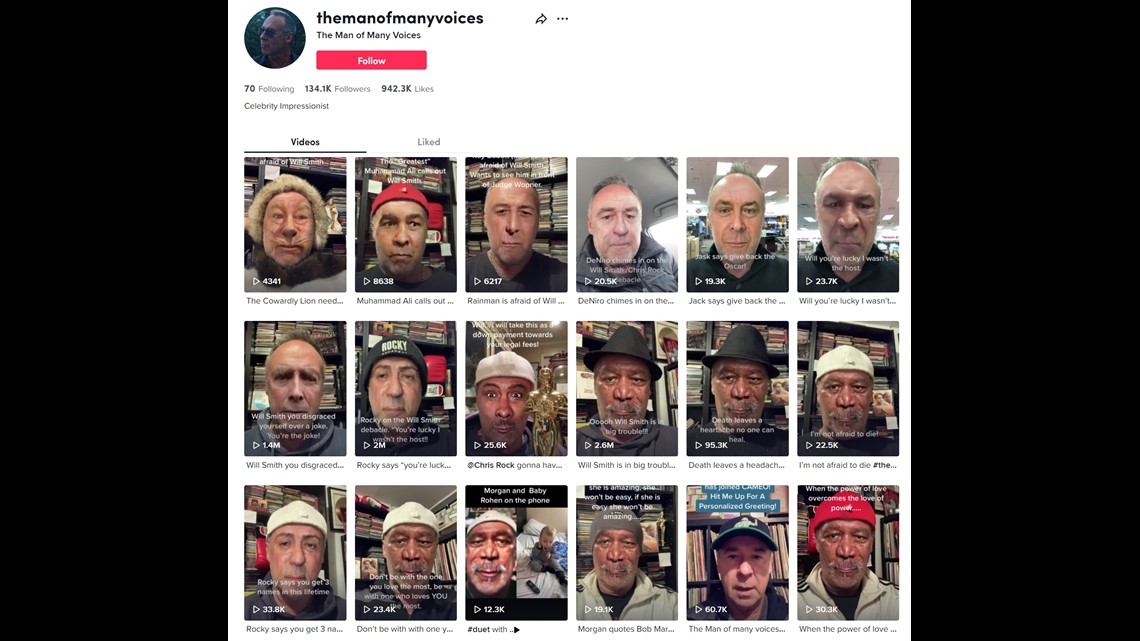

2022年奧斯卡獎上,好萊威電影明星威爾·史密斯(Will Smith)掌摑事件引起全球關注,而在TikTok上有影片流傳有其他的演員如摩根·費里曼(Morgan Freeman)、克林特·伊斯特伍德(Clinton Eastwood)批評「威爾史密斯遇到大麻煩了!」

美國電視公司Tegna的《Verify》查核平台就在2022年發布文章指出,這些批評的影片都是深偽造假(Deepfake),是來自TikTok帳號「@themanofmanyvoices」所創作。

《Verify》指出,「這個帳號會定期發布不同名人的深偽影片,檢視其他影片,可看到背景都是裝滿 CD 的書架。」

圖2:TikTok帳號「@themanofmanyvoices」,其影片多為名人Deepfake影片/擷自@themanofmanyvoices

面對愈來愈多名人遭Deepfake所害現象,研究人工智慧、Deepfake中研院資訊創新研究所助理研究員陳駿丞分析,「深偽影片要達到良好的生成品質也需要大量的資料,名人、藝人等擁有較多公開的影片,等同提供深偽算法豐富的素材,」

陳駿丞也認為,針對可疑網站、影片中常常出現的名人,民眾應先保持著深偽造假的可能性。

但是深偽研究團隊,或是事實查核者能做什麼?陳駿丞則建議,可先針對這些影片作深偽分析,建立名人字典、資料庫造假資料庫,讓民眾能即時判斷。

Deepfake進化 假訊息案例將更多

「深度造假的技術正在不斷進化。」陳駿丞說。

最早的「深偽」是一套專門用來替換人臉的軟體名稱,是以「自動生成編碼器」的深度學習系統為基礎。而目前「Deepfake」已經成為利用深度生成技術生成影像、聲音、文字等多媒體內容的總稱,包括臉部特徵變換、性別與年齡轉換、圖像風格轉換。

隨著近年來深度學習技術模型技術「生成對抗網路模型」(GAN)的快速發展,大幅提升做出高仿真內容偽造的效能,更降低其製作內容的門檻。

陳駿丞舉例:「像是開發者可利用生成對抗網路的開源軟體,能輕易修改圖片、聲音、與文字等數位內容,又或是民眾可輕易下載使用的FaceApp軟體。」

圖3:民眾可隨時下載的Faceapp也是利用Deepfake技術/照片來源:達志影像

研究Deepfake技術的成功大學統計學系教授許志仲也說,深偽技術雖然越來越厲害,但是大家也有意識到這點。因此,部分公開的深偽相關技術漸漸地改成非公開,或是不提供自行訓練模型等,避免被濫用。

「但是,因為目前的許多硬體越來越好,訓練一個深偽模型的時間也會隨之下降,深偽假訊息影片出現的程度也會提高。」許志仲認為。

金融詐騙利用Deepfake之惡

深偽內容的氾濫,早成為詐騙的犯罪手法,近期就有詐騙方利用Deepfake影片詐騙金錢、感情的案例,演變成另一場科技犯罪風暴。

陳駿丞老師分享,早在2019年,英國一間能源公司的CEO,因為接到德國母公司上司一通電話,要求他緊急將780萬台幣,匯至指定供應商的帳戶。而該CEO自認對於上司聲音相當熟悉,所以接到電話之後不疑有它,就派人去轉帳了,但上司的聲音是透過聲音轉換(Voice Conversion)的技術偽造的。可見聲音深偽早已成為詐騙手法之一。

到了2022年,包括特斯拉總裁馬斯克、幣安高層都被詐騙集團利用Deepfake侵詐他人錢財。

科技、資安媒體《bleeping computer》報導,2022年5月,一家名為「BitVex」的假加密貨幣平台,利用Deepfake影片,冒充馬斯克身份,宣稱是該平台的執行長;發布馬斯克Deepfake影片,宣稱馬斯克利用該平台賺進高獲利,進行加密貨幣交易詐騙。

Deep fake video of Elon Musk promoting crypto scam from BleepingComputer.com on Vimeo.

另根據英國科技網站《The Register》報導指出,2022年8月,幣安(Binance)首席通訊長(CCO)Patrick Hillmann 表示,駭客集團利用他過往的新聞採訪和電視畫面,用Deepfake冒充他的長相,用視訊軟體Zoom詐騙加密貨幣社群成員。

直到有人告訴Hillmann:「很高興在視訊會議上與你交流」,他才發現不對勁。

圖4:詐騙集團利用深偽技術以視訊軟體進行詐騙。圖為情境照,並非當事人。

「隨著不斷推陳出新的深偽模型,將會導致詐騙層出不窮。儘管有些生成的影像和聲音的品質不佳,但在手機上播放,由於銀幕的大小,以及影片解析度有限,民眾仍難判斷其內容是否被動過手腳。」陳駿丞指出。

許志仲也說,雖然現在的Deep fake的技術越來越成熟,但是在製作影片的階段,若仔細觀察仍能用肉眼找出破綻。也因此,「深偽影片通常會刻意降低其影片品質,讓民眾難以辨識細節,以混淆視聽。」

深偽影片偵測工具

在查核深偽影片的過程中,查核中心多次與許志仲老師合作,以老師的團隊所開發的偵測技術,協助辨認影片是否含有深偽技術。

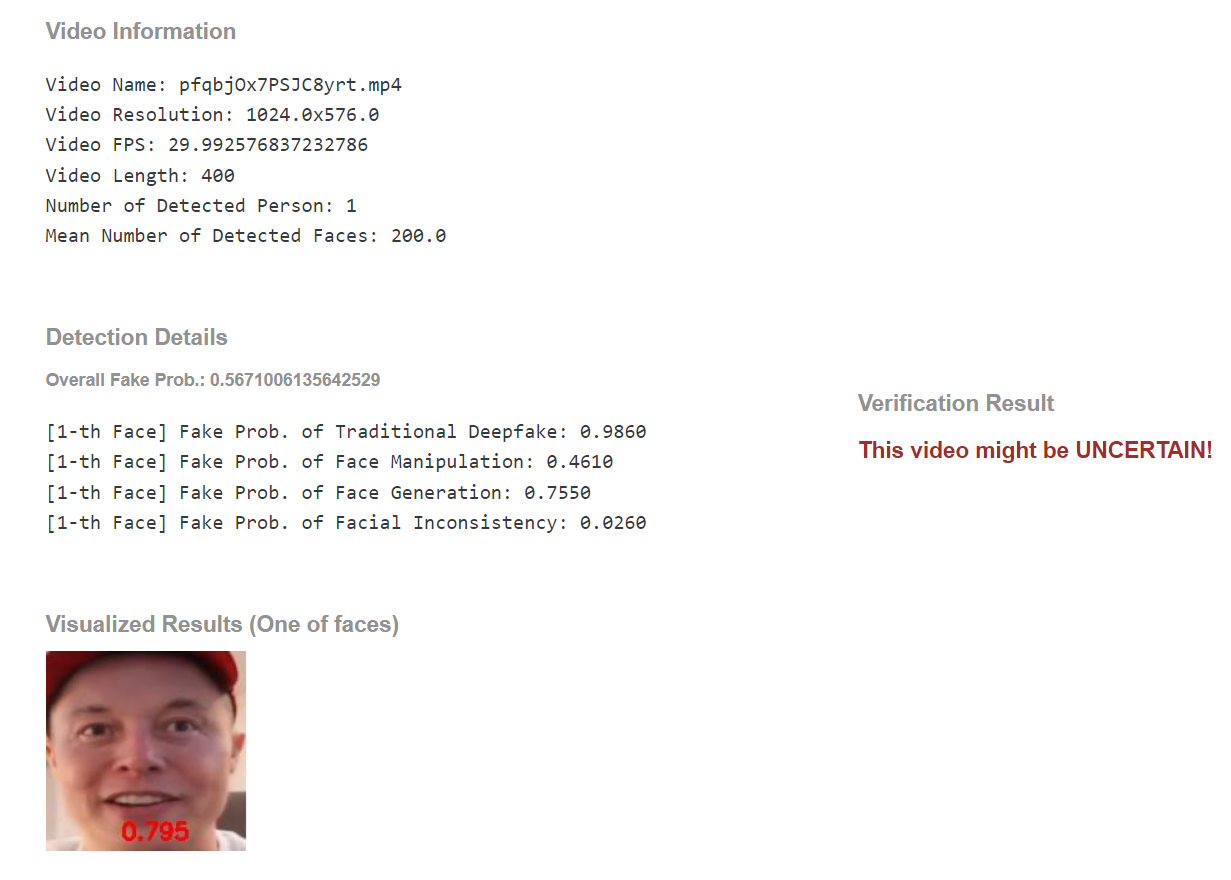

以近期破解的馬斯克深偽影片為例,許志仲老團隊的分析結果顯示,馬斯克的影片有高可能性是利用 Deep fake 產生。

圖5:許志仲老師偵測結果/圖片來源:許志仲提供

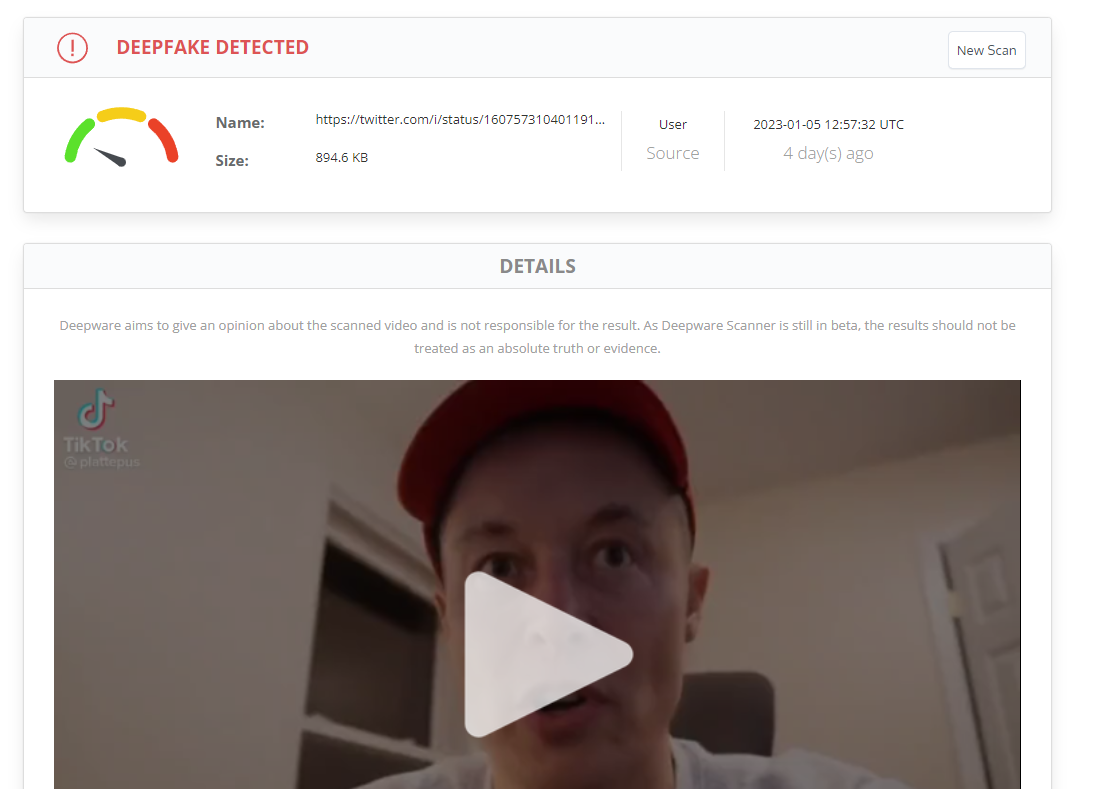

事實上,網路上也有開源的深偽偵測工具,如國外開發的偵測軟體「DeepWare」,民眾都能免費自行使用。例如,查核記者也實際用「DeepWare」偵測馬斯克的深偽影片,結果顯示,影片高度可能含有深偽技術。

圖6:記者實際偵測結果/擷自「DeepWare」

對於偵測軟體偵測的「結果」,許志仲說,在網路上可以找到的工具,通常都會出現類似各項分析的「結果」,而不會很肯定說一定是假的。這是因為 「Deepfake 技術種類很多,更重要的是,也會考量到軟體也有可能有偵測錯誤的時候。」。因此,民眾解讀結果仍需小心,且也只能當作初步的判斷!

用肉眼抓出影片「破綻」 反擊Deepfake造假

除了偵測工具,目前深偽影片製作仍有破綻,民眾仍可以用肉眼來辨認,許志仲老師、陳駿丞研究員也傳授肉眼辨認技巧,記者以下整理為四個技巧:

辨認技巧1:影片裡背景區域是否模糊

辨認技巧2:注意人臉區塊是否閃爍、臉部輪廓是否自然

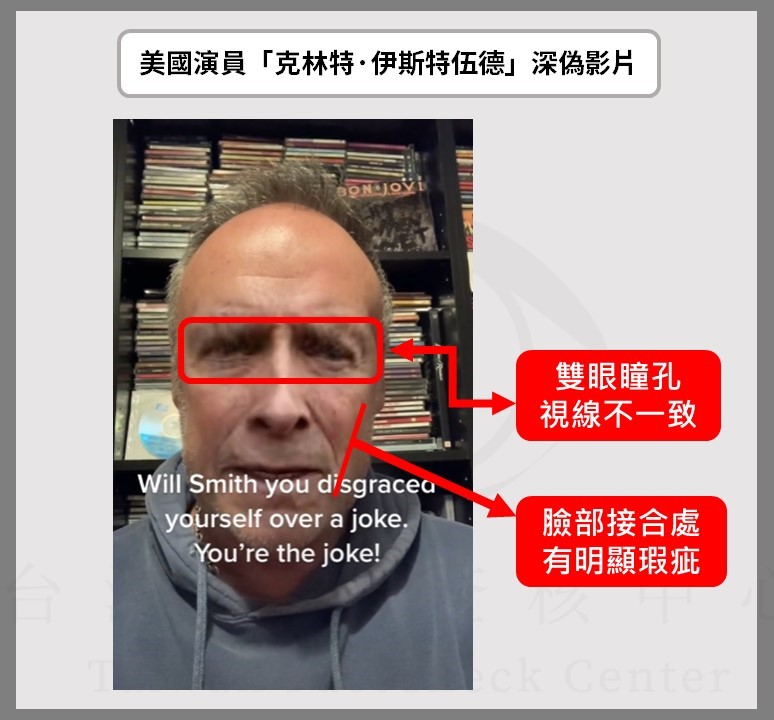

可注意臉部輪廓邊緣的紋理是否自然、接合處是否有明顯瑕疵、影片跨幀時,臉部輪廓或紋理是否有失真,或講者在有大幅度移動作時,其紋理是否正常。

辨認技巧3:注意眼睛瞳孔是否不規則

人的瞳孔是橢圓形,但生成模型生成的瞳孔通常為不規則,而且雙眼視線不一致。

辨認技巧4:注意嘴型、表情與聲音是否吻合

可以觀察連續撥放影片過程中的人物臉部狀態,特別是嘴型可能會出現不太連續,或是開合不自然,就可能是深偽影片。某些深偽技術,並沒有辦法讓說話者的聲音與嘴部影像達到十分吻合與同步。

目前深偽造假技術還沒辦法做到同時模仿一個人的表情與聲音情緒,也可以透過檢驗聲音中的情緒,以及他的面部表情是否吻合來辨別真偽。

圖7:檢視名人深偽影片,可發現其雙眼瞳孔視線不一致,臉部接合處也有明顯痕跡/台灣事實查核中心製圖

有識讀意識就是行動的第一步

儘管以目前的技術來說,民眾仍能利用免費偵測工具,或是用肉眼抓出深偽影片破綻。但許志仲老師也提醒:

「隨著技術的進步,很多原本有的瑕疵,也會漸漸被改良;且如果民眾沒有仔細看,或是保持警覺心,其實還是非常容易被誤導。」

面對日新月異、全方位的造假技術,許志仲說,除了深偽之外,偽造影片並不是只有換臉,移花接木,或是剪輯片段,都是不實訊息的一種。

許志仲也認為,提升全民的數位素養素質,才是有希望的策略;陳駿丞也說,傳統的眼見為憑不再一定為真,民眾對深偽或是相關AI議題有更深的認識,才是破解深偽行動的首要之任務。