【Global Fact 11】歐、印對抗選舉假訊息 印度深偽項目奪創新合作獎

記者何蕙安/塞拉耶佛報導、主編/陳偉婷

今年是全球大選年,加上生成式AI技術來襲,各界憂心選舉不實訊息衝擊全球民主。日前於塞拉耶佛舉行的第11屆事實查核峰會(Global Fact 11),歐洲選舉項目Elections24Check與印度項目Deepfakes Analysis Unit(DAU)分別分享兩區域查核組織如何合作,加打擊錯誤資訊的力道與影響力,啟發全球查核組織。

其中印度的合作項目DAU組成多元,集合印度多家查核組織、還有海內外的AI技術鑑識單位與研究團隊,合力對抗AI選舉假訊息,拿下了今年Global Fact 11事實查核獎的「創新合作獎」。

圖1:印度多家查核組織組成的AI假訊息合作項目Deepfakes Analysis Unit(DAU)在第11屆全球事實查核峰會上拿下「最創新合作獎」,圖為參與DAU的印度查核組織代表。(IFCN提供)

考量錯假訊息跨國界、跨平台流傳的特性,區域合作逐漸成為主流,目前在歐洲、非洲、拉丁美洲、阿拉伯世界與印度,當地查核組織陸續成立相對成熟的查核聯盟。前述Elections24Check就是歐洲事實查核標準聯盟(EFCSN)項目之一。除此之外,亞太區事實查核組織也趁著在塞拉耶佛聚首的機會,探討建構亞太區的聯盟。

印度:深偽分析部隊由查核組織與鑑識專家聯手打擊AI假訊息

去年11月,一段印度版遊戲問答節目「誰是百萬富翁」片段在網路熱傳。影片中,知名演員阿米塔布(Amitabh Bachchan)問參賽者:「有多少農夫受益於納斯(Kamal Nath)政府的貸款豁免方案?」然而這一題從來沒有在節目裡出現過。若細看影片,主持人的聲音與嘴形也對不上。

「一夕之間,『深偽』(Deepfakes)成為印度家喻戶曉的關鍵字。大家都在討論該怎麼對抗深偽。」印度查核組織Newschecker創辦人拉杰尼爾(Rajneil Kamath)在事實查核峰會回憶Deepfakes Analysis Unit(DAU,中文直譯為「深偽分析部隊」)成立的背景。

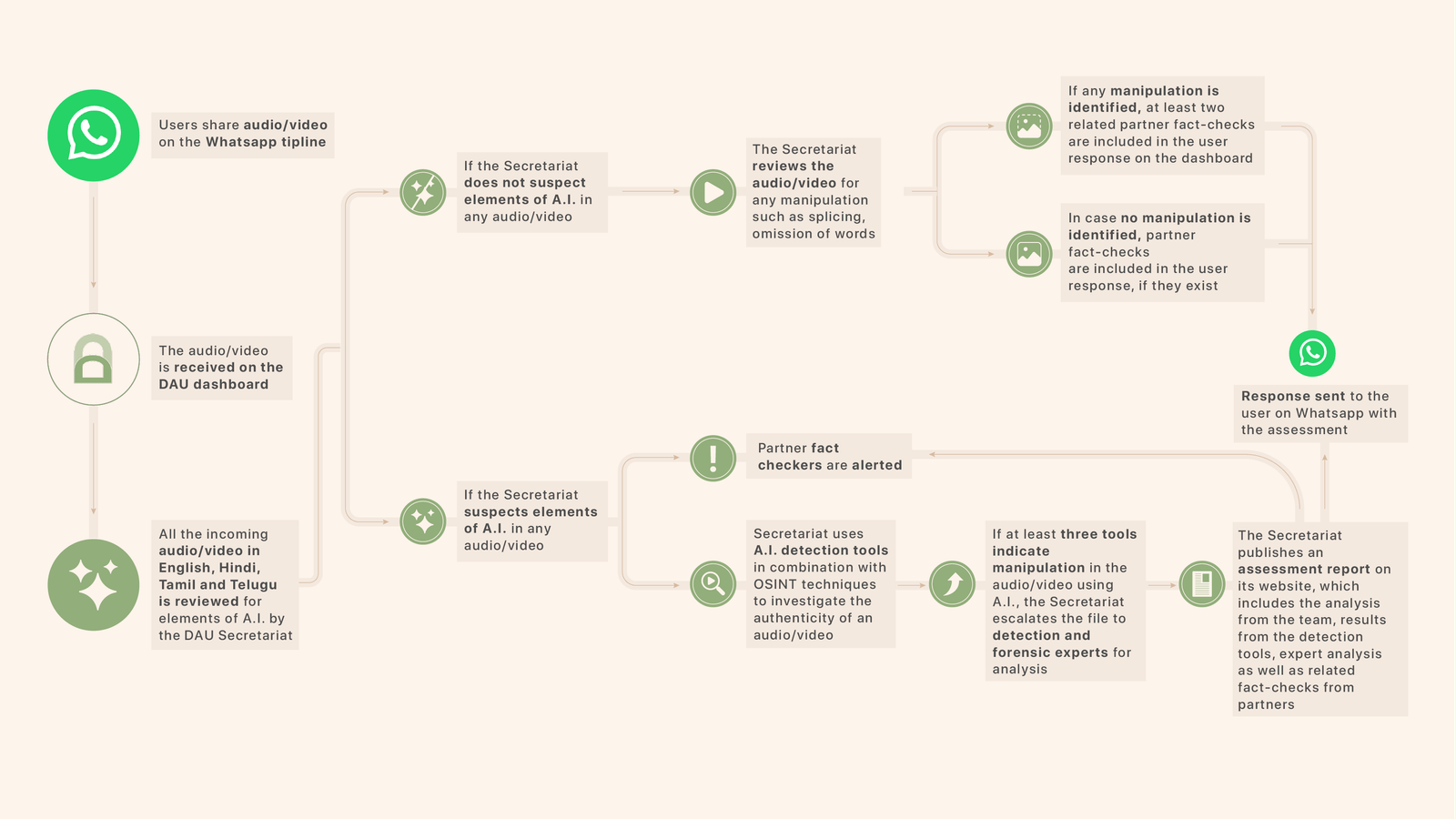

DAU項目由12家印度查核組織、6家印度與海外鑑識團隊以及學術研究單位所組成,主要使用WhatsApp聊天機器人蒐集與偵測可疑的AI影像或音訊內容,聊天機器人支持英文、印地語、坦米爾語與泰盧固語等4種語言。DAU項目獲得Meta資金支持。

這12家組織都是印度對抗錯誤資訊聯盟(Misinformation Combat Alliance)的成員。

拉杰尼爾說,接收到用戶提報後,DAU秘書小組會初步判定是否是AI生成。如不是AI,但內容仍是潛在的不實訊息,該內容仍會分享給所有事實查核夥伴。

若懷疑可能涉及AI技術,秘書會先以數個AI偵測工具與開源工具進行調查,並同步通知所有查核夥伴提高警覺;若工具分析結果判定是AI內容,則DAU小組會將該內容發給專業鑑識夥伴,再將專家鑑識結果與查核結果製作成分析報告,公布在網站且透過聊天機器人發送給用戶。

圖2:DAU工作小組收到民眾透過聊天機器人提報可疑內容後的作業流程。(擷自DAU網頁)

自2024年3月25日上線後,截至6月9日,DAU聊天機器人共收到372個影音內容,並分析242個內容。其中工作小組針對有高新聞關注度、高風險、高瀏覽量的內容,發布24篇深度的分析報告。

「DAU模式證實可行的。」拉杰尼爾強調,因為有一個團隊專門偵測與警示深偽與AI內容,加上與所有查核組織分享分析結果,不只增加查核團隊的能量與工作效率,也使得各組織在選舉的重大時刻得以即時應對高風險的AI假訊息。他透露,DAU將持續運作,不會因為印度大選結束而停止腳步。

圖3:印度查核組織Newschecker創辦人拉杰尼爾(Rajneil Kamath)2024年6月27日在第11屆事實查核峰會上回憶DAU成立的背景。Newschecker是DAU的事實查核夥伴之一。

印度:堅持使用至少3個工具偵測分析疑似AI內容

拉杰尼爾也分享DAU過去幾個月處理AI內容的經驗。首先,必須了解每個AI偵測工具的強項與弱點。由於不同的AI偵測工具通常只能偵測特定的造假方式,例如換臉、AI擬聲(voice cloning)、對嘴形、臉部合成、背景、人像生成等,涉及不同的偵測技術,若使用偵測AI擬聲的工具去偵測換臉內容,可能就會偵測不出來。

「不可以完全依賴AI偵測工具。」拉杰尼爾也強調,每個工具的可信賴程度與用於訓練的數據不同,使用不同的工具可能會得到不同的結果。因此,DAU小組在初步分析內容時,要求必須使用至少3個不同的偵測工具,以提高準確性。

其中,聲音的辨識難度最高,並且在印度選舉的後期較頻繁出現。拉杰尼爾指出,人的聲音可能隨著情緒的不同而聽起來不一樣,也較易被模仿。例如印度有個知名演員因聲音具有高識別度,甚至有專屬聲音演員替他接廣告配音。因此,儘管有時偵測工具判定某段聲音不是AI生成,也未必就是真實的聲音。

「記得要考慮各種可能性,不要假設你收到的影片是以AI生成。」拉杰尼爾提醒,實務上,以傳統手法造假的案例仍較為常見,例如把不同的片段剪輯在一起、或是刻意剪掉部分內容,這種手法無法使用AI偵測工具辨識,也曾發生過有心人士濫用偵測工具、來為以傳統手法造假影片增加可信度的情況。

歐洲:46家組織發布2500查核報告 打造歐洲第一個選舉假訊息資料庫

歐洲的合作項目Elections24Check則因應2024年6月舉行的歐州議會選舉而生,目標是偵測與破解歐洲選舉的假訊息,同時將夥伴組織的查核報告與相關數據匯集成資料庫,藉此觀察與掌握歐洲選舉錯假資訊的流傳情況與論述。

截至6月底,46家查核組織已累積產製超過2500篇查核報告或文章,來自35個歐盟國家與34個語言。這個項目獲得Google News Initiative的資金支持。

圖4:歐洲選舉查核項目Elections24Check的網頁。(擷自Elections24Check網頁)

Elections24Check網站提供包括所有參與組織組織涉及歐洲選舉的政治查核、網路查核、提前破解文章(Prebunking)與解釋性文章。除了分享彼此的查核成果,多家組織也透過資料庫的數據,發布各自的分析報告。

資料庫的數據為分析報告提供了強而有力的證據。例如根據西班牙查核組織EFE Verificat的分析顯示,許多帶有誤導性的資訊利用造假或是移花接木的影片誇大移民與難民對社會的威脅,高達20%的移民相關不實訊息將移民與犯罪連結在一起。

另家西班牙查核組織Maldita.es則利用該資料庫分析社群平台對錯誤資訊的行動。根據其追蹤,YouTube對高達75%的錯誤資訊沒有任何作為,X(前Twitter)則是70%;與之對照,臉書回應88%的錯誤資訊,Instagram處理了7成,TikTok則對40%的錯誤資訊採取行動。(編註:Meta平台在2016年推出第三方查證機制,與事實查核組織合作,對查核組織提報的錯誤資訊採取相應措施,如降觸及或移除。)

這個資料庫也開放給研究者研究,截至今年6月底,已有39個研究團隊提出申請,研究包括協同分享行動、生成式AI在假訊息行動中的應用、外國操弄、平台措施等。

台灣:公共政策查核、謠言劇本 TFC多管齊下打擊假訊息

有超過80個國家、全球大約一半的人口在今年選出國家領導人或國會議員,其中台灣大選在1月13日率先登場。為了應對台灣選舉不實訊息,台灣事實查核中心也祭出多項措施,包括成立公共議題查核專區,查核候選人關於公共政策的發言,並針對選舉期間多個重大爭議議題發布深度的解釋性文章。

查核中心也在總統辯論會時同步查核候選人的發言。在辯論會結束當晚,發布22篇查核報告。此外,查核中心根據歷年處理選舉的經驗,發布「選務謠言劇本」,預告在選舉不同階段可能出現的錯誤資訊。

同時,面對可能的AI假訊息威脅,查核中心也提前準備,並將重點放在培力台灣媒體偵測與應對。查核中心在2023年下半年陸續彙整AI相關查證資源與工具,制定AI查核流程準則,並舉行AI不實訊息工作坊,連結台灣媒體從業人員與AI專家。查核中心也製作互動小遊戲,分享辨識AI生成內容的秘訣,該遊戲也入圍今年事實查核獎的「創意查核報告格式獎」。

推薦閱讀

【Global Fact 11】130家查核組織聯手發布「塞拉耶佛聲明」以事實查核守護言論自由

.png)